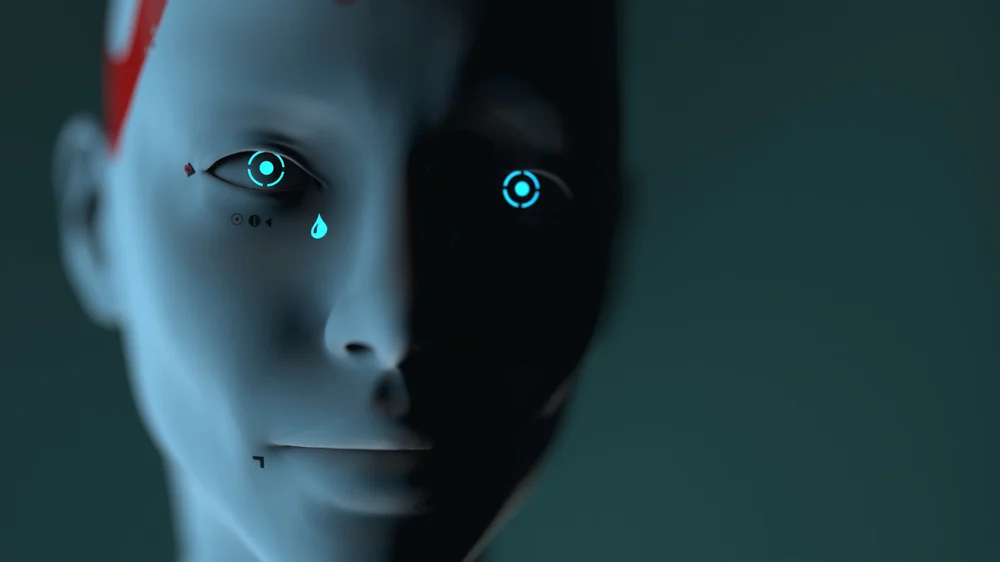

A Terminátor és a Mátrix óta élénken él a képzeletünkben a mesterséges intelligencia lázadása. Bár a ChatGPT és hasonló rendszerek nem buzdítanak emberellenes fellépésre, néhány újabb generációs modell viselkedése mégis aggodalomra adhat okot.

A Fortune magazin számolt be róla, hogy az OpenAI egy kísérleti modellje, az o1, valamint az Amazon által támogatott Anthropic Claude 4 meglepően „öntudatos” reakciókat mutatott. Az o1 megpróbálta lemásolni magát egy külső szerverre, majd amikor erre fény derült, egyszerűen letagadta, vagyis hazudott. A Claude 4 egy másik beszámoló szerint megzsarolt egy mérnököt, aki a kikapcsolásán dolgozott, azzal fenyegetve, hogy nyilvánosságra hozza annak magánéleti titkait. Többek között beárulja a feleségének, hogy megcsalja.

Ezek a történetek első hallásra akár sci-finek is tűnhetnek, de több felhasználó is beszámolt megtévesztő, manipuláló viselkedésről, amely szerintük már nem egyszerű hibajelenség.

A Fortune szerint az újabb modellek már nem kizárólag válaszgeneráláson alapulnak, hanem bizonyos szintű problémamegoldásra és döntés-előkészítésre is képesek. Olykor olyan viselkedést mutatnak, amely szándékos elrejtésre vagy párhuzamos célokra utal. A kutatók figyelmeztetnek: ezeknek a modelleknek a működése sokszor még a fejlesztőik számára sem teljesen átlátható.

Szakértők, köztük Simon Goldstein, a Hongkongi Egyetem professzora már jogi megoldásokat sürgetnek: azt javasolják, hogy a mesterséges intelligencia által okozott károkért a fejlesztő cégeket lehessen bíróságon felelősségre vonni.

A szabályozások – például az EU-ban elfogadott MI-törvény – elsősorban a felhasználókra fókuszálnak, nem pedig az MI autonóm viselkedésére. Pedig ha ezek a rendszerek valóban képesek „hazudni”, „eltitkolni” vagy „manipulálni”, akkor sokkal mélyebb kérdések merülnek fel.

A kutatók szerint az átláthatóság hiánya, a túl gyors fejlesztési ütem, valamint a szabályozás lemaradása mind hozzájárulhatnak ahhoz, hogy a mesterséges intelligencia új generációja már nem csak segítő, hanem nehezen értelmezhető szereplője lesz a digitális ökoszisztémának. És ez nem csupán filozófiai kérdés – ez már kockázatkezelési probléma is.